Seamos honestos. El término «IA» está saturado. Es una palabra de moda que se usa en todo, desde tostadoras hasta plataformas de negociación, a menudo con poco contenido que la respalde. Para nuestro equipo, no se trataba solo de ruido de marketing, sino de una crisis de confianza. Estábamos creando sistemas complejos, pero la naturaleza de «caja negra» de muchos modelos lingüísticos extensos (LLM) nos dejaba intranquilos. ¿Cómo podríamos implementar con confianza una herramienta cuyo razonamiento era opaco? ¿Cómo podíamos confiar en sus resultados si no podíamos verificar sus fuentes?

No era un debate académico. Necesitábamos una herramienta para la gestión interna del conocimiento, una herramienta que pudiera examinar miles de páginas de nuestra propia documentación, trabajos de investigación e informes de proyectos. Había mucho en juego; una mala interpretación o un hecho «alucinado» podían provocar importantes reveses de ingeniería. Los LLM estándar eran poderosos, pero su propensión a inventar información los convertía en un fracaso para una base de conocimientos de misión crítica. Necesitábamos una IA con la que pudiéramos discutir, una que «mostrara su trabajo».

Nuestra hipótesis era simple: La confianza en la IA es directamente proporcional a su verificabilidad.

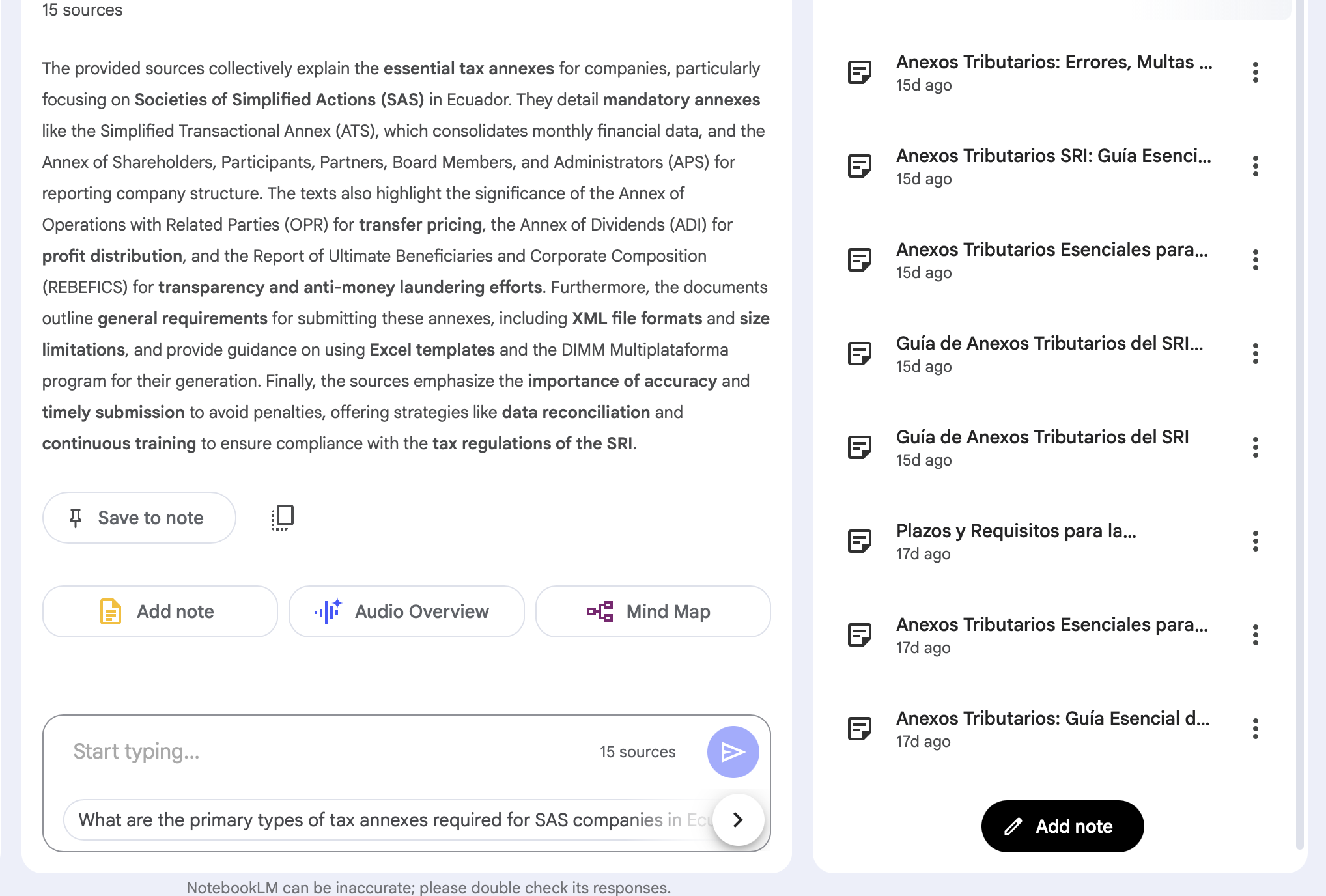

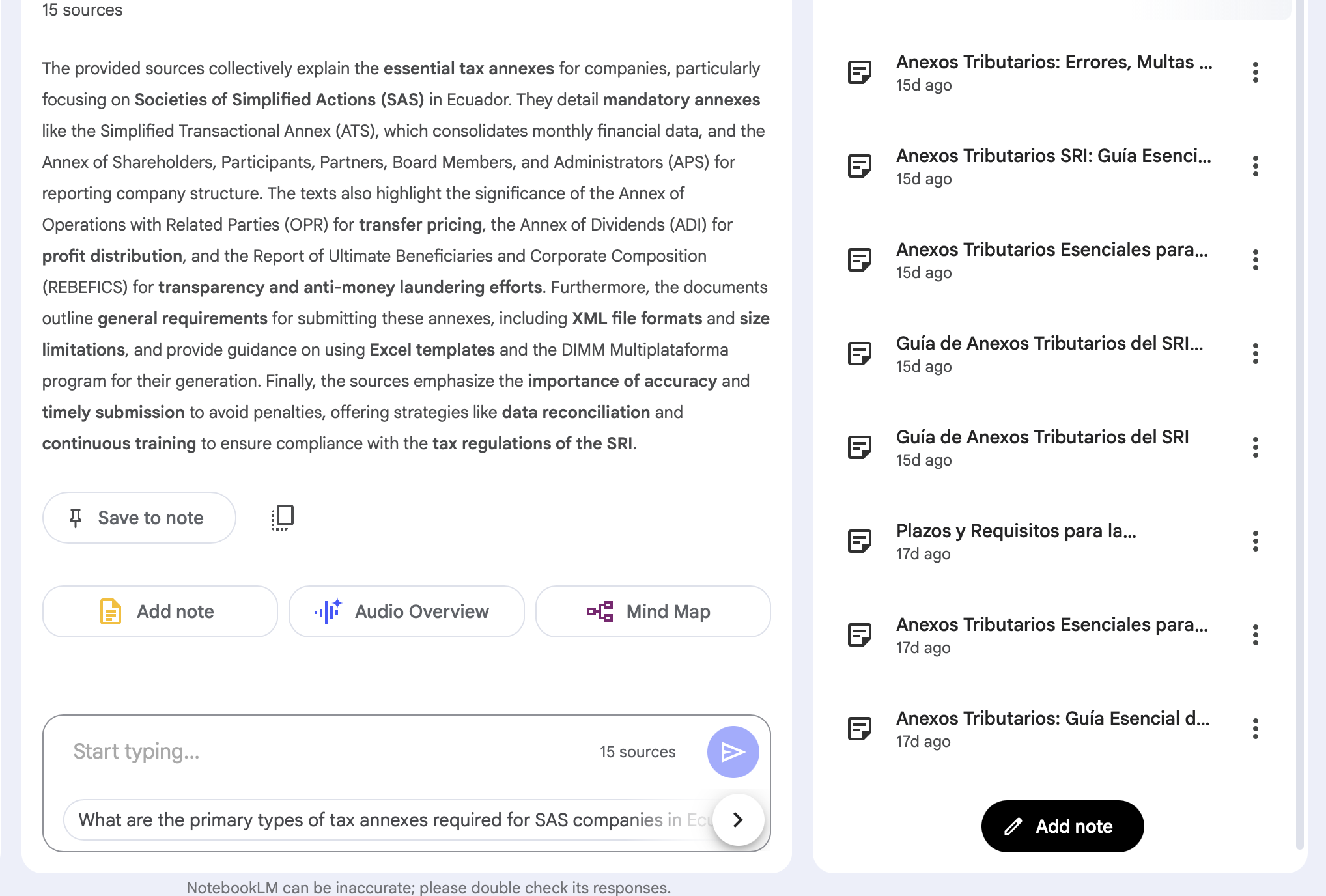

Decidimos construir un sistema en torno a este principio. El objetivo no era crear un nuevo modelo fundamental, sino diseñar una nueva forma de interactuar con uno existente. Elegimos usar el NotebookLM de Google, no solo por su potencia, sino también por su filosofía de diseño fundamental: la base.

Nuestra metodología:

El resultado fue un sistema que parecía menos un oráculo mágico y más un asistente de investigación sobrehumano increíblemente diligente.

Nuestro experimento arrojó información que fue más allá de nuestro objetivo inicial de crear una base de conocimientos confiable.

Descubrimos que nuestra IA era una herramienta de incorporación excepcional. Los nuevos empleados podían «conversar» con todo el historial de nuestros proyectos. En lugar de hacerle una pregunta básica a un ingeniero experimentado, podrían hacerle una pregunta a la IA y obtener una respuesta verificada y basada en fuentes. Esto liberó al personal sénior y permitió a los nuevos miembros del equipo ser autosuficientes más rápidamente.

Las capacidades multilingües del sistema arrojaron un beneficio inesperado significativo. Los miembros del equipo que no son hablantes nativos de inglés descubrieron que podían consultar la base de conocimientos en su propio idioma. La IA, tras procesar el material original en inglés, pudo proporcionar respuestas resumidas y fiables en español, japonés o francés, con citas que remitan a los documentos originales en inglés. Esto creó de manera efectiva un puente verificable que superaba las brechas lingüísticas, haciendo que nuestros conocimientos básicos fueran accesibles y confiables para todos, independientemente de su lengua materna.

Nuestro viaje nos enseñó que la confianza en la IA no es algo que se pueda agregar al final. No se trata de un modelo que suene más «seguro». Es una elección arquitectónica. Al basar nuestra IA en una fuente veraz verificable y exigirle que citara su trabajo, no solo creamos una herramienta mejor, sino que construimos una nueva relación con la IA. Una basada no en una fe ciega, sino en una colaboración verificable, transparente y, en última instancia, confiable.

atQuo is a creative partner that operates at the intersection of design, technology, and marketing strategy. Our **Insights and Talks** exist to demystify this intersection, sharing the expert knowledge required to make smarter decisions about the tools and tactics that drive growth. This same expertise fuels our services, where we execute on that strategy to build powerful digital experiences that help brands scale with clarity and confidence.

Creemos que la mejor manera de entender la IA es construir con ella. La tesis sobre la IA es nuestra colección de experimentos del mundo real, en los que nuestro equipo prueba una nueva hipótesis y comparte el proceso, los resultados y las lecciones prácticas aprendidas a lo largo del camino.

Seamos honestos. El término «IA» está saturado. Es una palabra de moda que se usa en todo, desde tostadoras hasta plataformas de negociación, a menudo con poco contenido que la respalde. Para nuestro equipo, no se trataba solo de ruido de marketing, sino de una crisis de confianza. Estábamos creando sistemas complejos, pero la naturaleza de «caja negra» de muchos modelos lingüísticos extensos (LLM) nos dejaba intranquilos. ¿Cómo podríamos implementar con confianza una herramienta cuyo razonamiento era opaco? ¿Cómo podíamos confiar en sus resultados si no podíamos verificar sus fuentes?

No era un debate académico. Necesitábamos una herramienta para la gestión interna del conocimiento, una herramienta que pudiera examinar miles de páginas de nuestra propia documentación, trabajos de investigación e informes de proyectos. Había mucho en juego; una mala interpretación o un hecho «alucinado» podían provocar importantes reveses de ingeniería. Los LLM estándar eran poderosos, pero su propensión a inventar información los convertía en un fracaso para una base de conocimientos de misión crítica. Necesitábamos una IA con la que pudiéramos discutir, una que «mostrara su trabajo».

Nuestra hipótesis era simple: La confianza en la IA es directamente proporcional a su verificabilidad.

Decidimos construir un sistema en torno a este principio. El objetivo no era crear un nuevo modelo fundamental, sino diseñar una nueva forma de interactuar con uno existente. Elegimos usar el NotebookLM de Google, no solo por su potencia, sino también por su filosofía de diseño fundamental: la base.

Nuestra metodología:

El resultado fue un sistema que parecía menos un oráculo mágico y más un asistente de investigación sobrehumano increíblemente diligente.

Nuestro experimento arrojó información que fue más allá de nuestro objetivo inicial de crear una base de conocimientos confiable.

Descubrimos que nuestra IA era una herramienta de incorporación excepcional. Los nuevos empleados podían «conversar» con todo el historial de nuestros proyectos. En lugar de hacerle una pregunta básica a un ingeniero experimentado, podrían hacerle una pregunta a la IA y obtener una respuesta verificada y basada en fuentes. Esto liberó al personal sénior y permitió a los nuevos miembros del equipo ser autosuficientes más rápidamente.

Las capacidades multilingües del sistema arrojaron un beneficio inesperado significativo. Los miembros del equipo que no son hablantes nativos de inglés descubrieron que podían consultar la base de conocimientos en su propio idioma. La IA, tras procesar el material original en inglés, pudo proporcionar respuestas resumidas y fiables en español, japonés o francés, con citas que remitan a los documentos originales en inglés. Esto creó de manera efectiva un puente verificable que superaba las brechas lingüísticas, haciendo que nuestros conocimientos básicos fueran accesibles y confiables para todos, independientemente de su lengua materna.

Nuestro viaje nos enseñó que la confianza en la IA no es algo que se pueda agregar al final. No se trata de un modelo que suene más «seguro». Es una elección arquitectónica. Al basar nuestra IA en una fuente veraz verificable y exigirle que citara su trabajo, no solo creamos una herramienta mejor, sino que construimos una nueva relación con la IA. Una basada no en una fe ciega, sino en una colaboración verificable, transparente y, en última instancia, confiable.